LLM(大規模言語モデル)とは?生成AIとの違いや得意な業務も紹介

ChatGPTをはじめとしたAIサービスの普及により、LLM(大規模言語モデル)という言葉を耳にする機会が増えています。しかし、「名前は聞いたことがあるものの、仕組みや何ができるのかはよく分からない」「生成AIやChatGPTとの違いが曖昧」という方も多いのではないでしょうか。

本記事では、LLMの基本的な仕組みから関連用語との違い、得意な業務、企業で活用際の注意点などを解説します。

目次

LLM(大規模言語モデル)とは?

LLMとは、インターネット上の膨大なテキストデータとディープラーニングを用いて構築された、文章の生成・理解に特化したAIモデルです。従来のモデルと比較して、計算量やデータ量、パラメータ数が大幅に強化されており、人間のように自然な文章の生成や文脈理解が可能です。

RNNやLSTMと呼ばれる従来のモデルでは特定の作業(翻訳だけ、感情分析だけなど)ごとに個別のモデルを作る必要があり、長い文章の文脈を正確に捉えることも苦手でした。一方で、LLMはひとつのモデルで多様なタスクをこなせる汎用性を備えているのが特徴です。

代表的なLLMのモデルには、OpenAIの「GPT」やGoogleの「BERT」などがあります。

LLMの仕組み

LLMは「トークン化」「ベクトル化」などの手順を踏んで言語処理を行っています。

仕組みを理解すれば、LLMを「制御可能な道具」として捉えられるようになり、どこに気を付ければよいのか、どのように業務に活用できるのかがイメージできるでしょう。

1.トークン化

トークン化は、入力されたテキストをコンピュータが処理できる「トークン」という最小単位に分割する工程です。英語は単語ごとに分けられますが、日本語は「私/は/サッカー/が/好き/です」のように分割されます。

AIはこのトークンの連なりとして言葉を理解するため、処理能力や利用料金も文字数ではなく「トークン数」を基準に計算されるのが一般的です。

トークン化は数値データに変換するための不可欠な前段階です。どのように言葉を区切るかによって、モデルが捉えられる意味の最小単位が変わるため、LLMの理解力や処理精度を直接左右する重要な要素となります。

2.ベクトル化

分割されたトークンをコンピュータが解析できる「ベクトル(数値データ)」に変換するベクトル化の処理を行います。

単なる数値化ではなく、意味が似ている単語同士を数値空間上で近い位置に配置する「単語埋め込み」という技術が用いられているのが特徴です。たとえば、「リンゴ」と「ミカン」を近くに置くことで、LLMは言葉同士の意味に近さを計算できるようになるのです。

単語を意味ごとにベクトル化することによって、LLMは単なる文字列ではなく、言葉の関係性を理解した高度な処理が可能になります。

3.ニューラルネットワークによる予測

数値化されたデータは、複数の層をもつニューラルネットワークに入力されます。

ニューラルネットワークは人間の脳の神経回路を模した構造で、「入力層」「隠れ層」「出力層」の3層で構成されているのが特徴です。データがこれらの層を通過する際、各層で特徴が抽出・分析され、最終的に次に続く言葉が確率的に予測されます。

層が深くなるほど複雑な文脈を理解して、次に続く言葉を精度高く導き出せるようになります。

4.文脈理解

続いて、ニューラルネットワークに入力されたテキストデータの文脈や背景を理解していきます。

「Self-Attention(自己注意機構)」という技術が用いられ、文章内の各単語が他のどの単語と密接に関連しているかを自動で計算し、文全体の背景や意味を把握します。これにより、たとえば「橋」が川の構造物か食事の箸かを前後の関係から正しく判断できるようになるのです。

この仕組みにより、LLMは文章を単語の集合ではなく、意味のつながりをもつひとつの文脈として理解できるようになります。

5.テキスト生成(デコード)

最後の工程であるデコードでは、内部の数値データを人間が理解できる自然なテキストに変換して出力します。

学習結果にもとづき、次に続くのにもっともふさわしい単語やフレーズを確率的に選択し、文章を構築していきます。一度に文章を生成するのではなく、ひとつの言葉を選ぶたびに文脈を更新し、再び次の言葉を予測するというプロセスを、終了条件に達するまで高速で繰り返しているのです。

これにより、人間が読んでも違和感のない文章を作成しています。

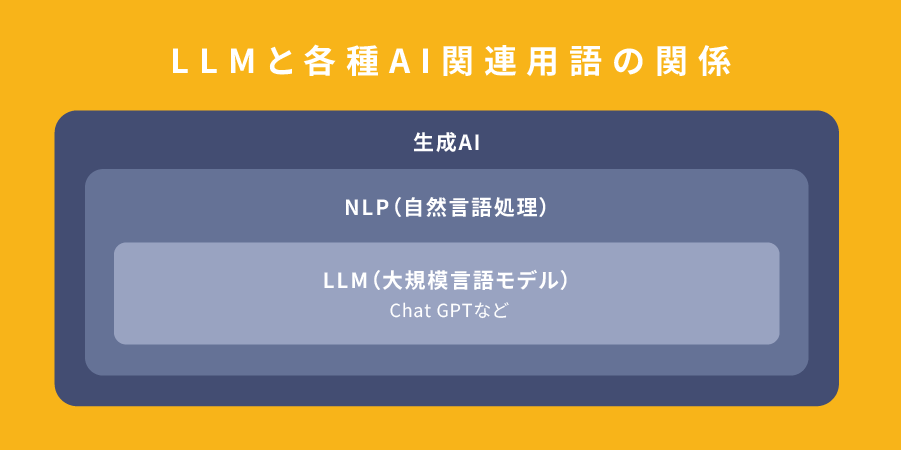

LLMと各種AI関連用語との違い

続いて、「生成AI」「Chat GPT」といった各種AI関連用語とLLMの違いを見ていきましょう。

これらの違いを正確に把握することで、正しいツールを選択できるようになります。

LLMと生成AIの違い

LLMは生成AIという大きなカテゴリに含まれる、言語特化の技術を指します。

生成AIは、文章や画像、動画、音声など、新しいコンテンツを自ら生み出す技術の総称です。一方、LLMは生成AIの一種であり、とくにテキストデータの生成や自然言語処理に特化したモデルを指します。生成AIは画像や動画など多様な形式を出力しますが、LLMは「言葉」に特化しており、人間のように自然で高度なテキスト回答を作成することに長けています。

業務で活用する際は「テキスト作業ならLLM」、「画像や動画の作成なら他の生成AI」というように、アウトプットが言葉かそれ以外かで判断するとよいでしょう。

LLMとChat GPTの違い

LLMは自然言語処理を可能にする技術基盤そのものを指し、Chat GPTはLLMを活用して開発された「対話型サービス」の名称です。

LLMは特定のパラメータにもとづき文章を生成するモデルであるのに対し、Chat GPTは人間との自然な会話に特化した具体的な製品という関係です。そのため、Chat GPTのほうが対話タスクに最適化されており、まるで人間と話しているような自然なやり取りができるよう設計されています。

自社専用の言語処理AIを活用したい人はLLMを、複雑な設定をせず手軽にAIを利用したい人はChat GPTを活用するとよいでしょう。

LLMとNLPの違い

NLP(自然言語処理)は言葉をコンピュータに扱わせる広い研究分野であり、LLMはそのNLP分野におけるひとつの手法です。

NLP分野では文章分類や感情分析、機械翻訳、音声認識、情報抽出などを含んでいます。一方で、LLMはNLPの中でも文脈の理解や文章の生成、理解に特化したモデルです。

NLPが「乗り物についての研究全体」だとすれば、LLMはその中で発明された「超高性能なロケット」のようなものといえるでしょう。

LLMと従来の機械学習の違い

従来の機械学習は人間が正解を教える特定タスク専用のモデルなのに対し、LLMは膨大なデータによる自己学習で多様なタスクをこなす汎用的な基盤モデルです。それぞれの技術が用いられたサービスとして以下のようなものが挙げられます。

| 従来の機械学習が用いられたサービス | LLMを活用したサービス |

|---|---|

| ・特定のルールにしたがって動くスパムメールの判定フィルタ ・あらかじめ決まったシナリオ通りに答える旧式のチャットボット |

・人間のように受け答えをするChat GPT ・膨大な社内文書から要点を即座に見つけ出すAIアシスタント |

従来の機械学習が限定的な用途に特化していたのに対し、LLMは幅広いタスクに対応できる汎用性の高さが最大の特徴です。

単一の目的に最適化されたツールを用いたいならば機械学習を、多様な業務や課題に柔軟に対応できるツールを用いたいならばLLMを導入するとよいでしょう。

LLMが得意な5つの分野

ユーザーが入力した文章の意味を理解し、テキストを生成するLLMは企業の業務効率化でも用いられています。主な得意分野として、「テキスト作成」「文章の要約」「質問への応答」などが挙げられます。得意な分野を理解し、より効果的な業務範囲でLLMを導入してみましょう。

また、スタディストではAIを用いて業務効率化を実現した事例を紹介しています。気になる方は以下のリンクよりご覧ください。

▼あわせて読みたい

関連記事:AIによる業務効率化の例を紹介!成功のポイントも解説

1.テキスト作成

LLMは、広告のコピー作成、メールの下書き、報告書の執筆などのコピーライティングを得意としています。膨大な学習データから次に続く言葉を統計的に予測するというLLMの仕組みにより、人間のように自然で文脈に沿った文章を構築できるためです。

たとえば、広告のコピーを作成する際には、ターゲット層やサービス特徴などの条件を指定すれば、複数の案を短時間で出力可能です。しかし、事実にもとづかない誤った回答や倫理的表現・著作権侵害のリスクが懸念されるため、必ず人間による最終確認を実施しましょう。

2.文章の要約

LLMに数千字に及ぶ長文やレポート、会議の議事録などを渡すことで、数行のポイントに要約することも可能です。LLMは文中の離れた場所にある単語同士の関係を計算できる仕組みであるため、長文でもどの言葉が主題に深くかかわっているのかを判別し、長文の要点を再構成できるのです。

箇条書きや表組みなどの形式指定、文字数の調整も実行できます。膨大な資料を短時間でインプットして要点のみを抽出できるため、情報収集や正確な情報整理に貢献します。ただし、重要情報を見落としたり、文脈を取り違えたりして、誤った回答を生成するリスクがあるため、出力内容の最終確認は不可欠です。

3.質問への応答

LLMは文脈の理解ができるため、ユーザーからの質問にも意図を理解して的確な応答を生成することが可能です。また、自社の製品マニュアルや専門知識などを別途学習させておくことで、専門的な質問にも回答できるようになります。

たとえば、カスタマーサポートのチャットボットにLLMを組み込むことで、24時間365日の自動で顧客の質問対応が可能になります。過去のFAQを学習させれば、回答精度を高めつつ、オペレーターの業務負荷を大幅に軽減できるでしょう。

4.多言語翻訳

LLMは海外の言語にも対応しており、100以上の言語で文脈やニュアンスを考慮した自然な翻訳が行えます。従来の翻訳ツールのような機械的な翻訳ではなく、丁寧な表現やフランクな言い回しの使い分けもできるのが特徴です。

正確な単語置換なら従来の翻訳ツール、プロンプトで口調やターゲットを指定して自然な文章に仕上げるならLLM、といった目的に応じた使い分けが有効です。一方で、専門用語を誤訳したり、主語を誤認したりするリスクがあるため、「用語集を事前に与える」「ニュアンスを明確に指示する」といった工夫も求められます。

5.コード生成

LLMに自然言語で指示をするだけで、PythonやJavaScriptなどのプログラミングコードを生成することも可能です。LLMではGitHubをはじめとする膨大なソースコードも学習しており、指示に対して目的の処理を実現するコードを確率的に予測して組み立てられるのです。

コーディング作業にLLMを活用することで、専門知識が少ない担当者でも、システム構築やウェブ制作の補助を受けられます。

しかし、LLMで生成されたコードは、脆弱性やライセンス侵害のリスクが指摘されています。動作保証もないため、必ず人間がテストやレビューを行い、セキュリティと著作権を確認しなければいけません。

LLMが苦手な3つの分野

LLMの得意分野がある反面、「最新情報の取得」「人間の感情や倫理にもとづく判断」「高い専門性が求められるタスク」といった、3つの分野は苦手とされています。

これらが求められる業務ではLLMの利用が向いていないため、業務効率化を目指す際は別の手段を検討してみましょう。

1.最新情報の取得

LLMはあらかじめ学習したデータを基に回答を生成するため、学習範囲外の最新情報には対応できません。当日のニュースやスポーツのリアルタイム動向、直近の出来事については、不正確な回答をしたり、「知らない」「分からない」という回答をしたりするリスクがあります。

そのため、情報の鮮度が重要なニュース要約や市場動向分析には不向きで、最新の時事問題に即座に対応すべきジャーナリストや証券アナリストなどの業務での単独利用は困難です。AIが生成直前に外部検索やデータベースを参照する「RAG(検索拡張生成)」技術を導入することで、最新情報を含めた回答が可能になります。

2.人間の感情や倫理にもとづく判断

LLMはデータにもとづいて論理的に回答を生成できるものの、人間の感情や倫理観を適切に理解・判断することは苦手です。デリケートな問題に不適切な表現を用いたり、文脈に合わない冷淡なトーンで回答したりするリスクがあります。

カウンセリングや人事評価など、感情の機微や高度な倫理判断が必要な対人業務では、適切な回答を生成するのが難しいため向いていません。他者への共感や信頼が必要な業務においては、LLMではなく専門資格をもつ「人間」が担うべきでしょう。

3.高い専門性が求められるタスク

医療や法律、高度な技術判断など、深い専門知識が必要な分野においては、LLMは不正確な回答や表面的な内容を回答する恐れがあります。診療方針の決定や法的助言などの重大なタスクにおいて、LLMの回答を過信することは危険であり、必ず専門家による確認と判断が不可欠です。

こうした業務においてLLMの回答は情報の一次選別や構成案の作成に留めるなど、「人間の専門家」をサポートする役割で活用しましょう。

LLMを企業で活用する際に押さえておくべき3つのリスク

LLMを業務で活用することで、0から人間が対応するよりも効率化できます。しかし、LLMを活用する際には、「ハルシネーションを起こす(誤った情報を出力する)」「情報漏洩を起こす危険性がある」などのリスクがある点を押さえておきましょう。

企業でLLMを導入する際には、上記のリスクへの対策も同時に検討するのが大切です。

1.ハルシネーションを起こす(誤った情報を出力する)

ハルシネーションとは、AIやLLMが事実にもとづかない情報を流暢に生成する現象を指します。これは統計的に「次に来る確率が高い単語」を予測するという、LLMの根本的な仕組みが原因です。

つまり、LLMを含むAI全般は、入力された情報の意味や文脈、背景などを理解しているものの、情報の正誤を判断しているわけではありません。

対策として、外部知識を参照する「RAG」の導入やプロンプトの工夫、追加学習(ファインチューニング)の実施が有効です。ただし、学習データの不足や偏りも影響し、現状では完全な防止が困難と言われており、最終的には人間によるファクトチェックを徹底する必要があります。

2.情報漏洩を起こす危険性がある

LLMに会社の機密情報や個人情報を入力すると、外部に流出したり、他ユーザーの回答に混入したりするリスクがあります。

LLMでは入力された文章や情報がクラウド上に保存され、追加学習に用いられる場合があります。社外秘の情報が追加学習されることにより、他ユーザーの回答へ混入する恐れがあるのです。

従業員へのLLM活用ガイドラインの策定に加え、入力データが学習に使われない法人プランの利用などが主な対策として挙げられます。社内業務にLLMを活用する際は、入力する情報は外部に公開してもよい情報にとどめ、入力する内容について厳格な管理が必要です。

3.コンプライアンス違反を起こす恐れがある

LLMでは学習データの偏りから、差別的・偏向的な表現を出力するケースがあり、その内容を企業業務で用いてしまうとコンプライアンス違反を起こす恐れがあります。また、生成物が第三者の著作権を侵害していたり、業界特有の規制(金融業における適合性原則など)に抵触したりする可能性もあります。

LLMを企業業務活用する際は、出力する内容が社内のルールや業界倫理に反していないか、人間の目で確認する体制を構築しなければいけません。

LLMのモデル選定のポイント

LLMを業務に導入するにあたって、OpenAIやAnthropicの「商用API」を利用するか、オープンソースのLLMを活用して「ローカルLLM」を利用するかの2通りが考えられます。

商用APIとは、OpenAIやGoogleなどのベンダーが提供する高性能なモデルにインターネット経由でアクセスし、従量課金制で利用する形態です。一方、LLMとは、外部のクラウドサービスを経由せず、自社のサーバーやPCなどの閉域環境で動作させる形態を指します。

それぞれの特徴は以下のとおりです。

| LLMのモデルの 種類 |

特徴 |

|---|---|

| ローカルLLM | ・機密情報の漏洩リスクが低く、カスタマイズ性が高い ・インフラ構築や運用の手間、高価なGPUなどの初期投資が必要 |

| 商用API | ・初期コストを抑えて最新モデルを利用可能 ・データ送信によるセキュリティ懸念や、利用量に応じたコスト増大のリスクがある |

独自の専門知識を深く扱う企業はローカルLLMを、自社でエンジニアを抱えるリソースが限られている企業は商用APIを活用するとよいでしょう。

まとめ

大規模言語モデルは、文章を理解し生成する技術として、多くの業務領域で実用段階に入っています。企業や個人が活用する際には、LLMの基本構造や得意分野と苦手分野を正確に把握することが重要です。

一方で、最新情報への非対応や誤情報を生成する可能性、倫理的判断の難しさといった課題も存在します。企業利用では、情報漏洩やコンプライアンス違反のリスクを想定し、運用ルールやモデル選定を慎重に行う必要があります。

そのため、企業でLLMを活用する際にはマニュアル作成が重要です。マニュアル作成・共有を効率化するなら「Teachme Biz」がおすすめです。

「Teachme Biz」に搭載された「Teachme AI」を活用すれば、LLMに渡してほしくないキーワードを入力するだけで、自社のLLM活用ガイドラインの構成案を作成できます。これらの機能によって、3時間かかっていたマニュアル作成をわずか15分程度に短縮した事例も存在します。

さらに詳しい情報を知りたい方は、以下から概要資料をダウンロードしてご確認ください。

Teachme Bizでは無料トライアルもご利用いただけます。導入を検討している方は、ぜひこちらからお問い合わせください。